Phân biệt Sigmoid với Softmax function UwU

Phân biệt sigmoid và softmax

Sigmoid và softmax là hai hàm activation vô cùng phổ biến. Bây giờ chúng ta hãy tới công thức cùng với ứng dụng của chúng nhé ╰(°▽°)╯

1.Sigmoid

1.1. Công thức

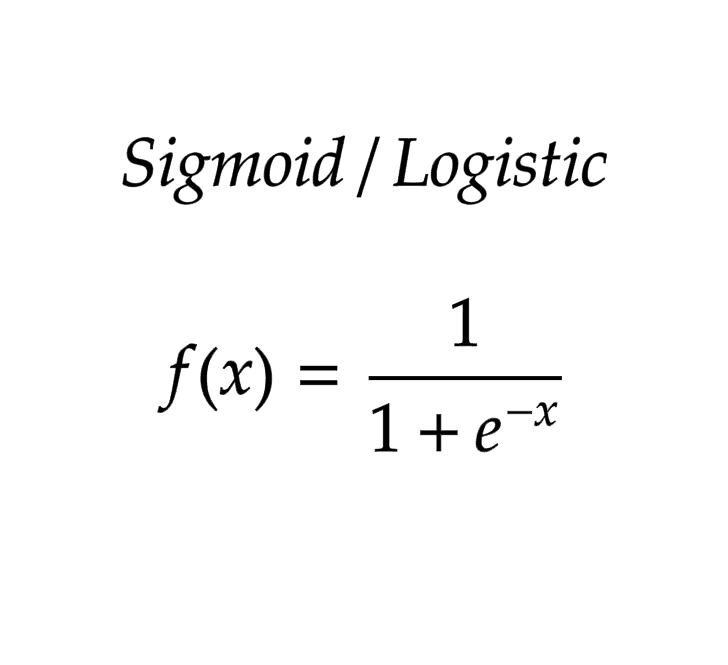

Đây là công thức của hàm 6 moi hay còn gọi là logistic function

1.2. Tính chất và ứng dụng của hàm sigmoid

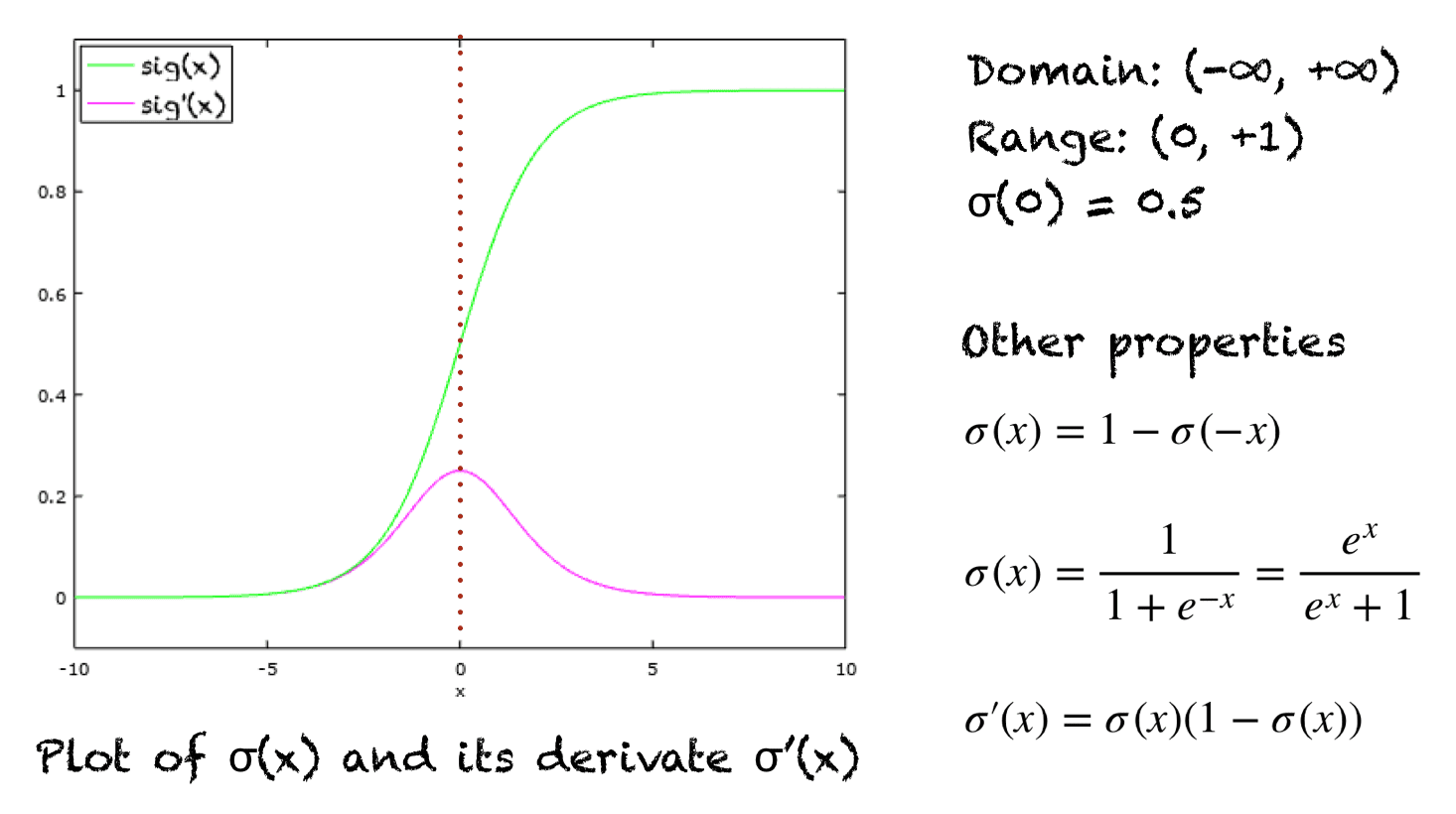

Nhìn vào hình trên, với đường màu xanh lá chính là hàm sigmoid, đường màu hồng là đạo hàm của nó.

Các bạn có thể nhận ra được một số điều như sau

- hàm sigmoid có thể được chia ra hai phần, phần bên phải 0 và phần bên trái 0

- phần bên phải 0 có range từ (0.5, 1), phần bên trái có range từ (0, 0.5)

- hai phần thay đổi nhanh vl, kiểu nó cố chạy về hai ngưỡng 0 hoặc 1

Việc với đa số x, thì hàm sigmoid sẽ nhận giá trị 0 hoặc 1 là vô cùng quan trọng. Tại saooo ? Vì nó phù hợp với bài toán binary classification, khi mà nhãn sẽ là 0 hoặc 1

1.3. Nhược điểm của sigmoid

Nhược điểm của nó nằm ở phần đạo hàm, khi hàm không thay đổi, thì đạo hàm của nó càng bé. Vì vậy, ở hai phần ngoài khoảng [-5, 5], đạo hàm của hàm sigmoid gần như bằng 0, mà đạo hàm bằng 0 thì làm sao mà update cho mô hình để mô hình học được.

2.Softmax

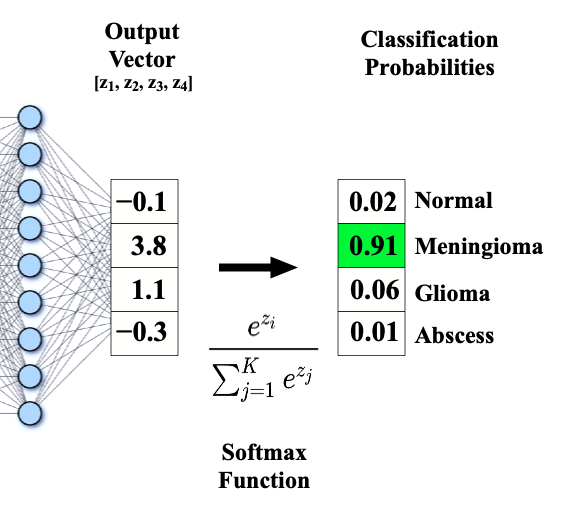

Dưới đây là công thức của hàm softmax

Mình thấy hai cái quần què này cũng k liên quan với nhau lắm, công thức của softmax bản chất là để chuyển cái output sang xác suất nhằm phục vụ cho bài toán classification.

Để dễ tưởng tượng, các bạn có thể nhìn vào hình sau:

Có thể thấy, từ một đống các output nhìn không hiểu gì lắm, sau khi đi qua hàm softmax, chúng ta có thể đọc chúng dưới dạng xác suất -> i zì.

All rights reserved